|

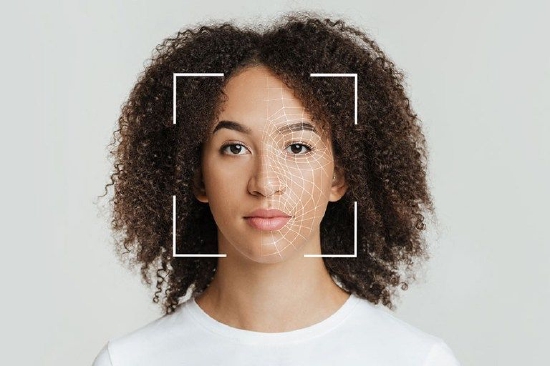

* q+ P! C6 |' [6 P- T 麻省理工学院的研究人员最近宣布他们已经训练了一个人工神经网络来处理面部情绪识别的信息,以帮助自闭症患者更好地识别人们脸上表达的情绪。

7 _% j( C, v, g9 r- R* F+ _, B7 c 对于许多人来说,很容易识别出他人脸上表达的情绪。微笑可能意味着幸福,而皱眉可能表示愤怒,但是自闭症患者在识别他人情绪时往往会遇到更多困难。目前尚不清楚为什么,但6月15日发表在《神经科学杂志》上的新研究揭示了大脑的内部运作,它使用AI来模拟人脑中的计算。 ; K( W1 l5 F5 v! A; d+ ^

& \2 Z; H) a$ f' U/ c# K 麻省理工学院研究科学家Kohitij Kar在麻省理工学院教授James DiCarlo的实验室工作,他希望能找到答案。Kar首先研究了另外两位研究人员提供的数据:圣路易斯华盛顿大学的Shuo Wang和加州理工学院的Ralph Adolphs。

, U/ ~, O1 v9 K8 l; p0 { 在一项实验中,他们向自闭症成年人和神经正常的对照者展示了面部图像。这些图像是由软件生成的,从恐惧到快乐不等,参与者迅速判断这些面孔是否描绘了幸福。与对照组相比,自闭症成年人需要在脸部表情更明显的情况下才会报告他们是快乐的。 7 e i0 g6 A7 ~2 K8 T* m4 Y+ ^

Kar训练了一个人工神经网络,这是一个受大脑结构启发的复杂数学函数,以执行确定面部图像是否快乐的相同任务。Kar的研究表明,自闭症成年人的感觉神经连接可能是嘈杂或低效的。根据Kar的研究,他认为这些视觉处理的计算模型在未来可能会有几种用途。

4 p! M- c" K; G1 M7 Y# J Kar表示:“我认为面部情绪识别只是冰山一角。”他认为这些视觉处理模型也可以用来选择甚至生成诊断内容。例如,人工智能可用于生成内容(如电影和教育材料),以最佳方式吸引自闭症儿童和成人。

# Q, y7 H5 t/ J 根据这项研究,这些计算模型可能被用来帮助调整AR眼镜中的面部和其他相关像素,以改变自闭症患者所看到的,也许可以通过夸大人们脸上的幸福感(或其他情绪)水平来帮助自闭症患者更好地识别情绪。根据麻省理工学院的说法,围绕AR的工作是Kar计划在未来追求的事情。

) }' A# |, b3 o; U; v3 k7 B" j" I7 v 即使以更简单的格式,安装了面部情绪识别软件的AR眼镜也可以检测人们的情绪并叠加文本提示,来帮助佩戴眼镜的自闭症患者,以便描述他们正在与之互动的人的可能情绪状态。根据Kar的说法,最终这项工作有助于验证计算模型的有用性,特别是图像处理神经网络。

' _ D' _0 k5 k r; k' v; {3 ~& r+ ~7 V1 X9 s

8 W% F' }. T% N- x' ~' ^

) \6 p6 Q3 [& z0 R1 X( o% u

+ c+ I+ d3 M& J$ e

8 G8 m$ p# p8 P+ E6 ~( U, m( t4 {: z

5 o6 u$ A/ s) k( Y; c0 @( x! h* J0 L

5 P( O+ D$ R* [, c* u( ?

! b: u/ N o4 Q3 w# H

) I' V- a2 r8 V* B, [ T |