|

$ ?9 O& B5 I {" s( _; e/ K 原标题:汇总教程 | 视觉/激光/多传感器融合SLAM,三维重建,运动规划,从入门到进阶!

7 ]- ?+ G5 I0 W% R

z+ z4 A$ r3 u! Y7 q 计算机视觉life”,选择“星标”

1 `" n" f3 a3 z: y4 V 快速获得最新干货 ' f" a- o* v# Y" Q

背景介绍

( x0 K* J& @4 M, O" G7 y 这两年 自动驾驶领域非常火热,发生了一轮又一轮的融资, 图森未来在美股上市,被称为“全球自动驾驶第一股”。 大疆创新正式推出旗下智能驾驶业务品牌“大疆车载”,华为、小米也纷纷下场。近日,自动驾驶干线物流企业千挂科技完成2亿元Pre-A轮融资,MINIEYE完成D轮累计8亿融资。。。 ! ^" i& B# p4 C

在 增强现实(AR)领域, Facebook已经从社交网络公司改名为元宇宙公司Meta,字节跳动重金收购AR/VR头显公司Pico,腾讯、阿里也纷纷入场,连罗永浩也告别了社交平台,将在AR领域再次创业,不知道是AR领域的明灯还是Ming灯。。。

3 X7 Q$ y9 }2 w( y8 u. d2 D4 w 在 机器人领域, 扫地机器人公司 石头科技上市, 物流机器人极智嘉在筹备IPO, 清洁机器人公司 高仙完成B+轮1亿美元融资。。。 9 u7 d: I u6 n' S# p5 S

在自动驾驶、无人机、增强现实、机器人导航等领域的技术栈中,即时 定位和建图(SLAM)是其中的核心技术之一。 SLAM中所涉及到的传感器有 相机、激光雷达、IMU、GPS、轮速计等,面对不同的平台和传感器配置,如何选择适合自己的技术方案呢? & \; x% w7 c& j/ N9 {

视觉SLAM基础 2 a+ v# i9 J1 q* a* V" J5 ~, I

ORB-SLAM2是业内最知名、应用最广泛的视觉SLAM开源代码之一。它有如下优点: 0 D Q, T5 D! p6 `

" z) S2 X) [+ z. K' Q5 t( W) P' F

支持 单目,双目和RGB-D相机的完整开源SLAM方案,能够实现 地图重用、回环检测和重新定位的功能。 : ]/ k9 \! C( r& A

支持轻量级定位模式,可以达到零漂移,此时不使用局部建图和回环检测的线程,可以用视觉里程计来跟踪未建图区域。 & w% q; r# m/ V# S7 X; m" ?+ b

采用ORB特征,具有旋转不变性、光照不变性、尺度不变性,匹配速度快,适合实时应用。无论是在 室内的小型手持设备,还是到 工厂环境的无人机和城市里驾驶的汽车,ORB-SLAM2都能够在CPU上进行实时工作。

" X0 K: I! `) m; m/ ]7 G, G 跟踪、局部地图、闭环、重定位等所有的任务都采用相同的ORB特征,使得系统内数据交互更高效、稳定可靠。

1 |- E* l6 k- I7 ?$ t 单目初始化和应用场景解耦,不管是平面还是非平面场景,都可以自动 初始化,无需人工干预。

/ {! K) Z: P s5 j1 l5 l$ l( r 地图点和关键帧创建比较宽松,但后续会进行严格筛选,剔除冗余关键帧和误差大的地图点,增加建图过程的弹性,在 大旋转、快速运动、纹理不足等恶劣情况下可以提高跟踪的鲁棒性。 2 v2 [( u2 Z W, {) r! T# j

采用共视图,使得跟踪和建图控制在局部共视区域,与全局地图大小无关,可以 在大场景下运行。 ! {- E% ]! z3 \& g/ f2 `* Y

使用本质图(Essential Graph)来优化位姿实现回环检测,耗时少精度高 。

5 r3 x7 k2 q6 a 相比于直接法,可以用于宽基线特征匹配,更适合于 对深度精度要求较高的场景,比如三维重建。 : |! }8 E! I! O7 P. d7 ]

定位精度高,可达厘米级,是特征点法SLAM的经典代表作品。 0 W2 }% j( x9 K: `

代码可读性强,包含很多工程化技巧,非常实用。 : L- |! N" u- C0 h8 ]7 p# S; k

% T! W. z3 @$ n) a ORB-SLAM2 用于室内三维重建 $ x. i- o2 R, `

ORB-SLAM2详细注释的代码持续更新,网址: % {+ `; a- h _& ]8 {3 w7 E& y7 ^

https://github.com/electech6/ORB_SLAM2_detailed_comments

T! z( r4 A" k# L 视觉惯性SLAM技术

7 a- u$ |+ p7 Z: Y j ORB-SLAM3是在ORB-SLAM2的基础上开发的视觉惯性SLAM技术,于2020年7月发布。它在定位精度和效果上几乎碾压了同类的开源算法,受到极大关注。

U" e4 m. z& b; B7 c2 } 它有如下特点: . _1 b+ P- Z1 h, O- M @1 O1 H0 S, g

1、 第一个可以运行视觉、视觉惯性和多地图,支持单目、双目和RGB-D相机,且支持针孔和鱼眼镜头模型的SLAM系统。 : ?9 _3 Y% N0 B. |+ R3 X* B6 v

2、该算法可以在不同大小,室内和室外环境中鲁棒、实时的运行,精度上相比于以前的方法提升了2~5倍。 + S' p1 e. C$ [4 V

3、 多地图系统可以让系统在视觉信息缺乏的场景下长时间运行。比如当跟踪丢失的时候,它会重新建立新的地图,并在重新访问之前的地图时,无缝地与之前的地图合并。 ' q8 D2 G- F$ d8 R1 `

4、实验结果证明,双目惯性模式下,该算法在无人机数据集EuRoC上可以达到平均3.6cm的定位精度,在手持设备快速移动的室内数据集TUM-VI上达到了9mm的定位精度。

- [* l$ C& M" t- q 从室内到室外,丝滑闭环 " h* e) T% \- M* k% [& V

全网最详细ORB-SLAM3代码注释地址:

1 s; e& V9 H- [- x https://github.com/electech6/ORB_SLAM3_detailed_comments ; c+ c& n5 l+ J. R; L* a) e: q

VINS-Mono/Fusion 系统教程

1 _; a9 D2 ?6 j/ Y/ u# Q4 R6 u" t VINS即Visual-Inertial navigation Systems,是视觉惯性导航系统的统称,不过我们平时所说的一般是指VINS-Mono/Fusion。 香港科技大学飞行机器人实验室(沈邵劼团队)在2018年开源了VINS-Mono算法。第一作者秦通(2019华为天才少年),该论文获2018年机器人顶级期刊IEEE Transactions on Robotics最佳论文奖。它用一个单目相机+惯性测量单元(Inertial Measurement Unit,简称IMU)实现了紧耦合的视觉和惯性联合状态估计,在保证高精度里程计效果的同时,还可以同时估计出传感器外参,IMU零偏以及传感器时延。2019年该团队开源了VINS-Mono的升级版VINS-Fusion,它支持多种视觉惯性传感器类型,包括单目+IMU,双目+IMU,以及纯双目。VINS-Mono和VINS-Fusion在当年一骑绝尘, 是非常经典且优秀的VIO框架。 ! d, L: a: w" H

以下是VINS-Fusion在汽车SLAM上的效果:

* g8 g. w# k( V, x9 t/ H* H/ K 以下是讲师详细注释的 代码地址:

. T: ^7 m+ K! B% t. y https://github.com/xieqi1/VINS-Mono-noted 7 r$ c5 T5 Y. K: d% M# Y

https://github.com/xieqi1/VINS-Fusion-noted I4 W) F, t+ F6 ^& V& f2 P" L

基于LiDAR的多传感器融合技术

3 J. v6 W$ k/ Z! v L5 ~2 G' W 多传感器融合SLAM是自动驾驶、智能机器人中的核心技术。 目前工业界用的主流多传感器融合SLAM框架包括LOAM/A-LOAM、LeGO-LOAM、LIO-SAM等。 2 {% P* D( b1 p4 U% O! [( y9 R& m

9 B' ~& X$ \7 e' [& r/ R7 l* o

LOAM是Ji Zhang早期开源的多线LiDAR SLAM算法。该代码可读性很差,作者后来将其闭源。

8 G+ r- u' v% O# P. @- L A-LOAM是港科大秦通博士(VINS-Mono一作)在LOAM原有代码基础上,使用Ceres-solver和Eigen库对其进行重构和优化,在保持原有算法原理的基础上,使其可读性大大增加,作为入门多线激光slam最好选择。

% r0 c& `% d% [' K5 J m2 U LeGO-LOAM 是Tixiao Shan在原有LOAM基础上,做了一些改进包括:1、对前端里程计的前量化改造,提取地面点更适配水平安装的LiDAR; 2、使用SLAM中的Keyframe概念以及回环检测位姿图优化的方式对后端进行重构。 $ I6 b% K# p' _" a a9 {) O

+ o$ g' M$ \- i4 x6 A# h3 ]

9 Y: K9 \/ ?9 x) K0 U

LIO-SAM 是Tixiao Shan在LeGO-LOAM的扩展,添加了IMU预积分因子和GPS因子:前端使用紧耦合的IMU融合方式,替代原有的帧间里程计,使得前端更轻量;后端沿用LeGO-LOAM,在此基础上融入了GPS观测。同时前端后端相互耦合,提高系统精度。 7 k/ f* o7 |9 Q3 I

3 r u; N0 [$ R( H/ q2 u% r9 _/ U

LIO-SAM 的效果 2 U" Q' g- K8 Y" G+ `

) X7 B4 x4 T7 ^2 U' q, N1 p LVI-SAM是Tixiao Shan 2021年最新的开源工作,他将LIO-SAM和VINS-Mono进行了结合,是一个通过平滑和建图实现激光雷达-视觉-惯性里程计的紧耦合框架,由两个紧耦合子系统组成:一个视觉惯性系统VIS和一个激光雷达惯性系统LIS。当两个子系统中的一个发生故障时,系统也可以发挥作用,这增加了它在无纹理和无特征环境中的鲁棒性 ( }- Y) L5 V$ T- j, ^: P8 B- g. p$ L9 r

* W% M- S4 ~; t! q0 W7 o4 n& K 独家注释代码 * b. f( J$ p1 f0 F& i

https://github.com/xieqi1/a-loam-noted R) W/ ^5 C' g: D; O k

https://github.com/xieqi1/lio-sam-noted

( e, e8 O" k# D https://github.com/electech6/LVI-SAM_detailed_comments

0 b6 a6 V& w& Q/ P5 }/ u" r8 Y 激光SLAM技术 R1 F" a5 I. @( y$ |. ]4 \

Cartographer是Google推出的一套基于图优化的激光SLAM算法,它同时支持2D和3D激光SLAM,可以跨平台使用,支持Laser、IMU、Odemetry、GPS等多种传感器配置。该算法可以实现实时定位和建图。 4 _; q0 w% I8 Q" {3 V

Cartographer建图过程

! d' m* C" |: E/ \: ? Cartographer建立的栅格地图可以达到5cm的精度,该算法广泛应用于服务机器人、扫地机器人、仓储机器人、自动驾驶等领域,是最优秀的激光SLAM框架之一。

1 q) q% Y' E) Z8 K4 }* j7 u Cartographer做了超详细源码注释 2 K! |3 p- b' h( v, f

https://github.com/xiangli0608/cartographer_detailed_comments_ws 7 Z, S/ u* H- O7 e

机器人运动规划 0 a5 x4 y/ n* L0 ~9 r/ }3 ]

运动规划和SLAM什么关系? $ y; W% C9 [3 [; r i

其实在企业里,SLAM算法工程师、运动规划工程师通常是 相对独立的岗位,SLAM技术通常可以得到稀疏的定位地图,结合后处理可以得到稠密的三维点云地图。此时我们需要用一定的规则将其转化为 栅格化地图,机器人在这个 地图的基础上进行运动规划(导航)。SLAM和运动规划是自主机器人的两个核心技术。 ) j$ m n' r+ l# ]

简单来说,解决机器人导航问题一般被称为运动规划,就是让机器人可以自主根据传感器获取外部环境信息,在当前环境中找到一条适合机器人行走的最佳路径。这不是一个简单的工作,因为地图可能发生变化,其他运动的物体也是必须要绕过的障碍物,所以常常需要更改自己的规划,如何在这种复杂的环境下高效率地实现最佳路径,就是运动规划的使命。

7 Q9 A5 B( _- c) W 运动规划在移动机器人的应用 & m% j$ H6 Q, A0 c+ f- t

独家注释代码 1 \1 m9 b5 u. S% K

https://github.com/felderstehost/ros-navigation-noetic 6 n% ^ y, m: v- s$ ?0 ?

视觉几何三维重建技术

5 J6 G% f& y( l3 U3 W

' |2 x6 b1 ?+ D& T% S* U7 j4 v2 R 三维重建是指用相机拍摄真实世界的物体、场景,并通过计算机视觉技术进行处理,从而得到物体的三维模型。英文术语:3D Reconstruction。

X6 _/ \& m, R7 n' t V 涉及的主要技术有:多视图立体几何、深度图估计、点云处理、网格重建和优化、纹理贴图、马尔科夫随机场、图割等。 7 O- e2 X4 [1 r% c

是增强现实(AR)、混合现实(MR)、机器人导航、自动驾驶等领域的核心技术之一。 三维重建结果9 F4 n8 \1 V6 p$ }( r& [

' X, n; F6 X0 m( y% `# c0 ~

全网最详细的代码注释地址:

1 C! [2 r9 X. o https://github.com/electech6/openMVS_comments

Q) x) c, V6 K9 _; P 深度学习三维重建技术框架 ; S" x5 \; g, c: G9 ?

传统的重建方法是使用光度一致性等来计算稠密的三维信息。虽然这些方法在理想的Lambertian场景下,精度已经很高。但也有一些常见的局限性,例如 弱纹理,高反光和重复纹理等,使得 重建困难或重建的结果不完整。因此,传统三维重建方法在重建的完整性等方面仍有很大的改进空间。 " ?2 `9 v# Y: h, }: v9 O

近年来深度学习在三维重建上取得了很大的成功。基于学习的方法可以引入比如 镜面先验和反射先验等全局语义信息,使匹配更加鲁棒,从而解决传统方法无法克服的难题。因此掌握基于深度学习的三维重建前沿算法非常重要。另外,在这个大数据时代,深度学习已经是大家必须掌握的技能,传统视觉算法已经很难有新的突破,各个领域都在朝深度学习方向研究,近几年各大视觉会议论文都是基于深度学习来实现三维重建,各个大厂招聘也越来越看重深度学习三维重建方法。

# r0 I- b" k- T ~+ o C++编程入门到进阶

. l1 F8 }, T9 Y% ` 很多初学SLAM的小伙伴都有个疑问:号称宇宙第一语言的Python,简单好用,包又多,功能又强大,为啥SLAM算法里很少使用呢? - t8 `* [6 f" E, s4 U9 {

SLAM知识星球嘉宾刘国庆在知乎做了回答 ) w2 q" V2 U" S2 `+ K7 g

这里再补充几点:

1 a* f6 k" f% U8 r0 ~/ E N* p* E# u0 {1 p) W2 h/ q( [4 w) x

C++具有 极高的性能和运行效率,很多语言都是在C/C++基础上封装的,比如Python。就这一点足以秒杀众多的高级语言。

, @; ~. c/ t6 S% H C++发展了三十多年一直是编程常青树,一直使用,一直在发展,C++岗位需求会 越来越旺盛,只增不减。 8 y+ g; H+ H) |: S

C++能够 操控底层,非常适合 和硬件打交道。 8 y" h3 X; t; T6 f6 ?! Y I

; k8 S# ^+ Q1 l) P |/ }

很多小伙伴都是机械、自动化、通信等非计算机专业,也没有经历过系统的C++训练,而在具体的项目中,比如SLAM算法框架中,通常的代码并不是我们在书上看到的那样简单直白。很多同学在学习SLAM的过程中感觉C++是一座难以跨越的大山, 学习过程漫长而痛苦,项目开发遇到bug也不会调试,书看完了代码还是不会写,代码一改就错,一错就懵。

/ l/ f" L: v& a0 O 相机标定技术框架 4 l- V2 d+ Q' ]+ C9 h1 a% c

# |& e5 K" |* U7 u 相机标定是指借助专用的标志物(如棋盘格)来估计相机的图像传感器参数(内参、外参)和镜头参数(畸变系数)。 . d8 @7 w5 {& s' l/ G0 I' V

它是一种计算相机二维图像和三维世界相对映射关系的一种方法。标定相机过程涉及相机成像模型、多视图几何、非线性优化等知识。 : w3 t% v$ N/ c! S' y" J, I+ T

相机标定是三维视觉的基础。 8 P6 p0 t5 x' W/ t9 G& m

Z' D/ p+ G4 B) d* g/ f

毫不夸张的说, 相机标定是一切三维视觉的基础。它广泛应用于 双目视觉、手眼机械臂、机器人定位建图、图像拼接、三维重建等场景。 1 t! Q/ v$ n% @: u0 n4 o1 `# V1 J* y' o

全国最大的SLAM开发者社区 o1 R. O* @! v3 h

SLAM社区:一个人啃SLAM,难受到自闭,硬顶还是放弃?

" h2 {2 P, _5 D9 ] 在我们的SLAM和3D视觉知识星球里,很多刚入门的同学问的最多的问题我总结了一下,主要有: 8 Q) b' @3 K8 b& M8 j+ ?+ Z- O

5 D5 g+ Z c& L, h6 _

机械/自动化/数学等非计算机专业能否转SLAM?

: ` e2 m( J6 r 导师不懂,但要我做SLAM方向,怎么入门?

0 i V- U, y# A7 i 编程基础差,数学不好,能否学习SLAM?

9 X. m2 V# U5 D# [! I, ]+ } 看完十四讲,下面怎么学习?7 h U. S/ _$ k4 H2 j; X# e% ^# S

需要学哪些开源框架?怎么学习呢?

! Q- Z& t) r7 X8 k& w% y& I2 [ 编译遇到很多问题,怎么解决?

+ z& S( V- F6 k, B/ s# A% B 只有自己一个人学SLAM,没人讨论好痛苦,怎么办?5 y1 H) O. i _( v2 b1 s

想要和小伙伴组队系统的学习,有资源吗?- l) S8 u/ m3 W- Z

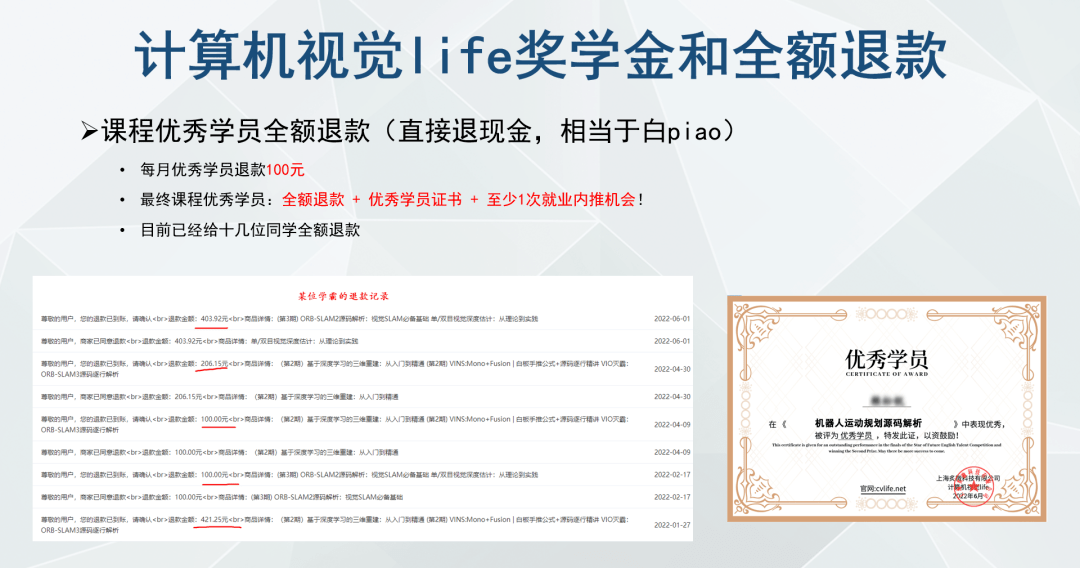

, o& L; Z. p. E0 ^ 我们建立了全 国最棒的SLAM和三维视觉交流社区,包括 小白入门图文/视频教程、学习过程疑难点解答、每日最新论文/开源代码/数据集分享、在线学习小组、笔试面试题、实习/校招/社招岗位推荐、星主直播交流等。 9 n1 Z8 l( A' w# Q

: Y. j2 B; G' u) [/ L: y 2018年创立、 3500+会员、 6100+主题分享、 9500+问答评论、 130+教学视频

% r3 i1 V6 t' O" e+ W 教程:图文视频教程、涉及 代码调试/OpenCV/PCL/G2O/Ceres/视觉SLAM十四讲/LVISAM/R3LIVE

' V* K5 c) d" F. a; } 资讯:每日论文分享、行业资讯汇总、每周汇总、精华汇总 + ?6 {+ [) L9 e4 x: I8 A

直播:每月至少3次,涵盖学习经验/求职面试/实习历程/行业介绍

, l2 e' q, n$ l6 o 活动:学习小组、行业资源对接、会员激励、有偿招募助教/兼职 ; ?8 `; b5 ]8 {4 o* f5 j

求职:内推职位、SLAM面试题、笔试练习

' @; q, g9 g5 G …… 0 Y5 l3 X9 y' `. E+ C( E

. j- x8 t, M6 [) ~

! f( F& Z W h+ R* Y9 M

独家重磅课程官网:cvlife.net ' Q2 O* ?% Q( h

1、SLAM社区: 一个人啃SLAM,难受到自闭,硬顶还是放弃?

+ d: B% E$ b' X# x0 E: E0 B 2、C++实战: 为啥SLAM代码都用C++不用Python?

c5 r/ V# ]" z- B/ S! j 3、多传感器融合SLAM 激光雷达-视觉-IMU多传感器融合方案!

7 V. {. c. u* u4 _$ Z8 H. V 4、VIO灭霸:VIO天花板ORB-SLAM3第2期上线!(单/双目/RGBD+鱼眼+IMU+多地图+闭环) / B) c8 j D8 m$ Q* f

5、视觉SLAM基础: 刚看完《视觉SLAM十四讲》,下一步该硬扛哪个SLAM框架 ?

* W5 k0 F4 z" Q, B. t; t+ h7 E 6、机器人导航运动规划: 机器人核心技术运动规划:让机器人想去哪就去哪!

8 h' U a& t6 R, ]" ~7 u+ q 7、详解Cartographer: 谷歌开源的激光SLAM算法Cartographer为什么这么牛X?

9 ^6 k ?, Q0 S) G# g9 | 8、深度学习三维重建 总共60讲全部上线!详解深度学习三维重建网络

$ V a, }- _* J4 h1 ?+ R: L0 P 9、三维视觉基础 详解视觉深度估计算法(单/双目/RGB-D+特征匹配+极线矫正+代码实战) - D& G5 Z. w, V% K) c! V# G

10、 VINS:Mono+Fusion SLAM面试官:看你简历上写精通VINS,麻烦现场手推一下预积分!

3 E. o: B1 Z7 @8 F 11、图像三维重建课程:视觉几何三维重建教程(第2期):稠密重建,曲面重建,点云融合,纹理贴图

6 Z0 c5 \ k2 v- p 12、系统全面的相机标定课程:单目/鱼眼/双目/阵列 相机标定:原理与实战 返回搜狐,查看更多 9 H4 k2 @/ q4 V) l; ]0 ^6 q4 O6 V

( ^0 o) E! y# z& J0 P0 R' |% T

责任编辑: 9 T6 U* |: C5 L4 D" r

5 l' F4 E! c0 u+ A& D1 u& [' F" T, ]

* n9 _% h C* x9 ]. N' l* S

4 C3 t/ f4 d- w2 U$ O( R |